在逛git论坛发现ChatGPT一个模型竟然开源啦~,提供多种多样的部署方法,这里拿Windows电脑做演示~

亮点

- 宽松的 Apache 2.0 许可证:自由构建,不受版权限制或专利风险 – 非常适合实验、定制和商业部署。

- 可配置的推理力度:根据您的具体用例和延迟需求轻松调整推理力度(低、中、高)。

- 完整的思路链:提供对模型推理过程的完整访问权限,从而简化调试并增强输出的可信度。此信息不打算向最终用户显示。

- 可微调:通过参数微调完全根据您的特定用例定制模型。

- Agentic 功能:使用模型的本机功能进行函数调用、网页浏览、Python 代码执行和结构化输出。

- 原生 MXFP4 量化:模型使用原生 MXFP4 精度针对 MoE 层进行训练,允许

gpt-oss-120b在单个 H100 GPU 上运行并gpt-oss-20b在 16GB 内存内运行。

部署

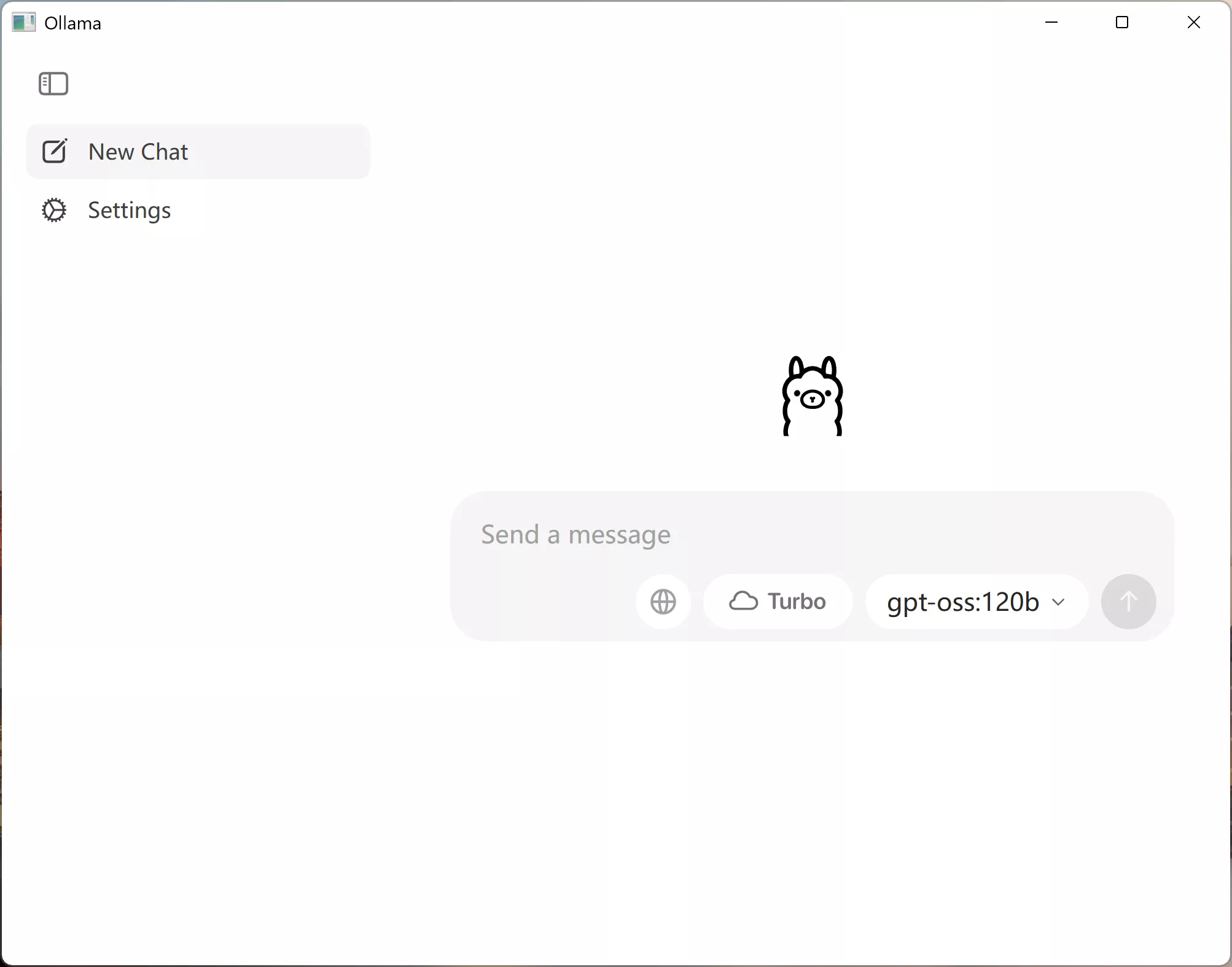

下载Ollama客户端

访问Ollama官网选择Windows下载安装包即可~

下载Python环境

访问Python官网选择Windows下载安装即可~

注意

安装时要选勾上把Python环境添加到系统目录下

安装模型

模型选择

gpt-oss-120b | gpt-oss-20b |

| 适用于生产、通用、高推理用例,适合单个 H100 GPU(117B 参数,其中 5.1B 活动参数) | 适用于较低延迟和本地或特殊用例(210 亿个参数,其中 36 亿个活动参数) |

警告

这两个模型都是使用OpenAI的和声反应格式进行训练的,并且只能与这种格式一起使用;否则,它们将无法正常工作。

下载模型

用管理员运行命令行窗口粘贴安装命令下载模型

下载语句(复制粘贴下载即可)

# gpt-oss-20b

ollama pull gpt-oss:20b

ollama run gpt-oss:20b

# gpt-oss-120b

ollama pull gpt-oss:120b

ollama run gpt-oss:120b

使用

打开Ollama客户端选择好下载好的模型使用即可~

引用资料

参与讨论